Back propagation 의 가장 핵심적인 미분 계산을 수식적으로 자세히 뜯어보고 이해해보자.

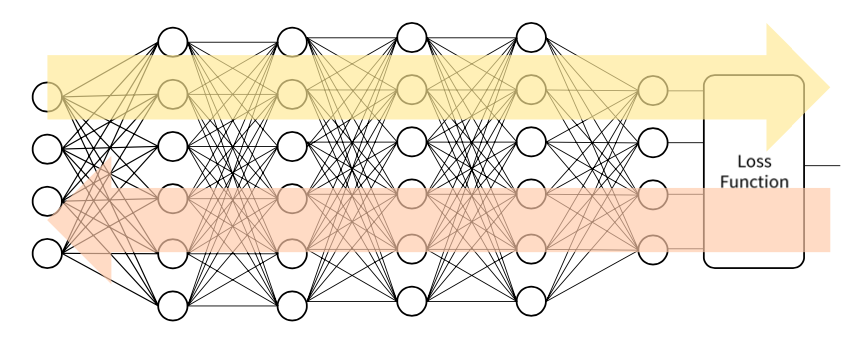

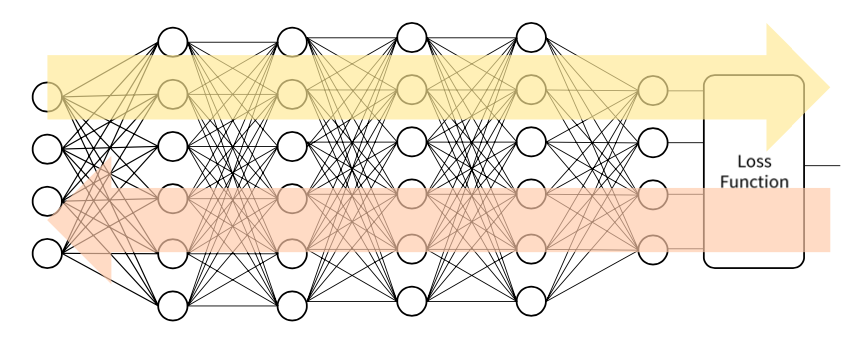

합성함수로서의 DNN

입력, 함수모델, 정답은 fix되어있다.

Activation function, loss function도 이미 정의가 되어있는 상태이다.

변할 수 있는건 Trainable parameter와 손실값(L) 밖에 없다.

그렇기 때문에 n번째 함수 fn은 n-1번째 데이터셋 값을 입력 받아서 Wn, bn 파라미터가 조건부로 들어가게 된다.

다 넣었으면 이제 데이터 셋의 입력과 출력 값은 중요하지 않게 된다.

손실을 최소화하는 파라미터만 찾으면 되기 때문이다.

DNN의 Chain Rule

Fully Connected Layer의 미분

Sigmoid 함수의 미분

Back Propagation Algorithm

'💡 AI > DL' 카테고리의 다른 글

| DL - tech interview (0) | 2022.04.11 |

|---|---|

| Chain Rule (0) | 2021.02.01 |

| DNN의 수학적 이해 (1) | 2021.02.01 |

| Deep Neural Network - Back Propagation (0) | 2021.02.01 |

| 심화 경사하강법 (0) | 2021.01.31 |