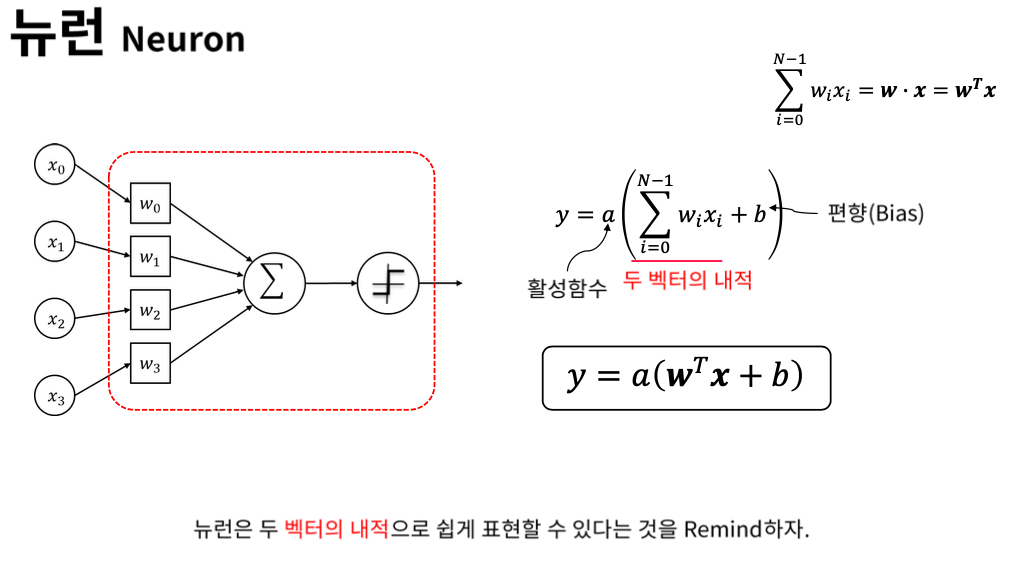

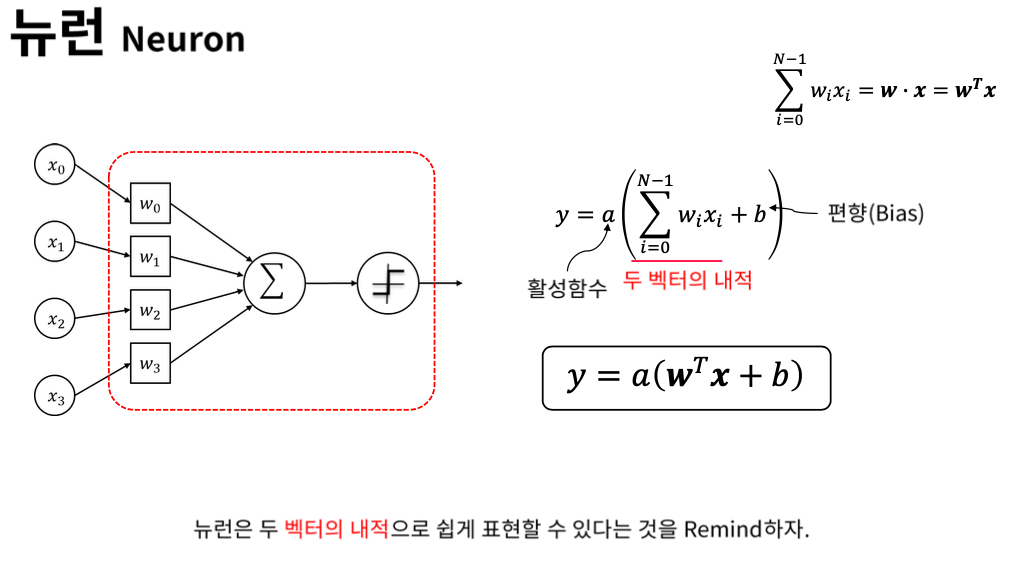

뉴런은 여러개의 입력을 받아 가중치를 곱해서 합해주고 non linear activation function을 이용해서 출력을 해주는 가장 기본적인 단위이다.

전결합 계층 (Fully Connected Layer)

모든 뉴런들을 연결한 Layer가 Fully connectecd layer이다.

간단한 matrix의 곱으로 표현할 수 있다.

볼드체(x, b, y)는 벡터이고 W는 벡터이다.

DNN

블랙 박스 모델 (Black Box Model)

손실을 최소화 하는 방향으로 학습한다.

어떤 블랙박스 모델이 있고 trainable parameter가 4개라고 해보자.

블랙 박스 모델의 학습

수치적 기울기 (Numerical Gradient)

에타값이 충분히 작다면 수치적 기울기를 미분값으로 사용할 수 있다.

블랙박스 모델의 Numerical Gradient

Gradient descent를 하기 위해서 Loss function을 세타로 미분했었다.

그러면 Gradient가 되고

a, b, c, d 에 대해서 각각 편미분한다.

각각의 변수마다 조금씩 바꿔서 계산해주어야 Numerical Gradient를 구할 수 있다.

DNN 의 Numerical Gradient

'💡 AI > DL' 카테고리의 다른 글

| Back-Propagation 의 Chain Rule (0) | 2021.02.01 |

|---|---|

| Chain Rule (0) | 2021.02.01 |

| Deep Neural Network - Back Propagation (0) | 2021.02.01 |

| 심화 경사하강법 (0) | 2021.01.31 |

| 경사하강법의 수학적 표현 (0) | 2021.01.31 |