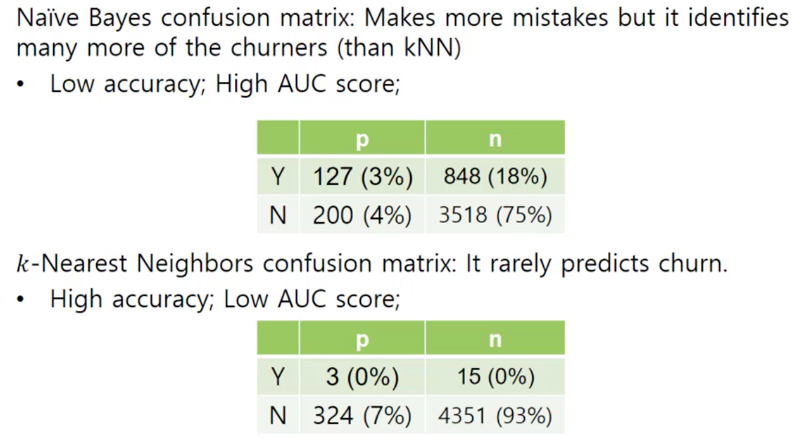

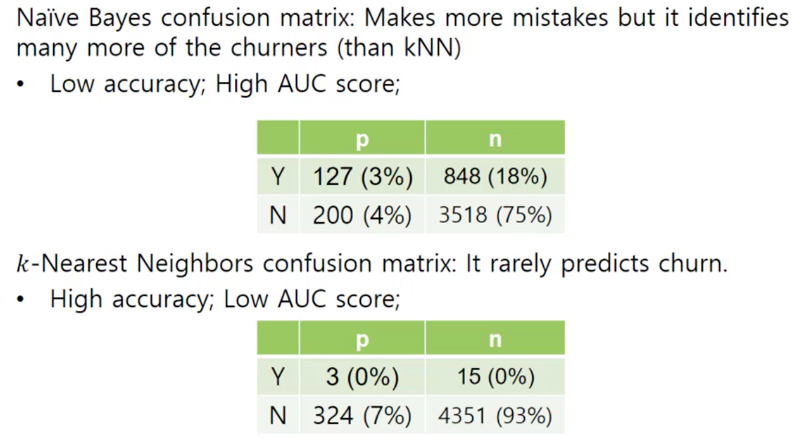

나이브 베이즈는 낮은 정확도 였는데 높은 AUC 값이 나왔다.

KNN은 Y로 예측 하는데 거의 0%이다. 전혀 못하고 있다.

반면 나이브 베이즈는 굉장히 실수를 많이 한다.

그러나 맞추는 거도 많이 한다.

ROC curve

위 그래프를 보면 높은 정확도를 갖는 kNN은 오버피팅 되었다는 것을 알 수 있다.

나이브 베이즈 > Decision 트리 > 선형 회귀 > kNN 순으로 정확도가 높은 것을 확인할 수 있다.

단, 일반화는 하지 말라. 데이터에 따라 다를 수 있다.

Lift Curve

Lift Curve에서는 x축이 테스트 인스턴스의 비율이다.

영양가 좋은 테스트 인스턴스를 주었을 때 거기에 얼마나 부응하느냐, 얼마나 퍼포먼스가 좋으냐 물어보는 것이다.

아무리 좋은 밥을 줘도 제 성능을 못하는 것은 좋은 Classifier가 아니다.

25퍼센트 까지만 타겟한다면 트리가 좋은 것이고 더 많이 하면 나이브 베이즈가 더 좋은 Classifier 이다.

그럼 좋고 나쁘고 그럴 그때마다 Classifier를 바꿀 수 있나?

그건 어렵다.

모델이 테스트하는 데이터는 entire한 데이터에 관한 것이기 때문에 중간에 바꿀 수 없다.

Profit Curve

얼마만큼의 이득을 챙길 수 있을까?

홍보하기 위한 비용 : $-3

이득 : $30

respond 한다면 한사람당 : $27

respond 안한다면 홍보 비용 : $-3

9:1 정도의 Profit ratio 를 나타낸다.

이득을 $39로 높인다면

12:1 의 Profit ratio가 됐다.

그런데 재밌는 현상이 일어났다.

20% 에서 가장 큰 이득을 보여주고 있고

35% 정도 가면 나이브 베이즈가 가장 큰 이득을 보여주고 있다.

25%에서 두가지는 만난다.

이전 그래프와 다르다.

Cost와 Benifit을 다르게 할수록 Profit Graph가 반응에 따라서 의사 결정이 달라지기 때문이다.

'💡 AI > ML' 카테고리의 다른 글

| ML W13 - Representing and Mining Text (0) | 2021.06.11 |

|---|---|

| ML W12-2 - Evidence and Probabilities: Prediction via Evidence Combination (0) | 2021.06.10 |

| ML W11-2 - Visualizing Model Performance (0) | 2021.05.15 |

| 미니 프로젝트 (0) | 2021.05.13 |

| 꼭 알아야할 ML 용어 (0) | 2021.05.09 |