CNN - Activation function (활성화 함수)

2022. 1. 20. 10:16

🖼 Computer Vision/CNN

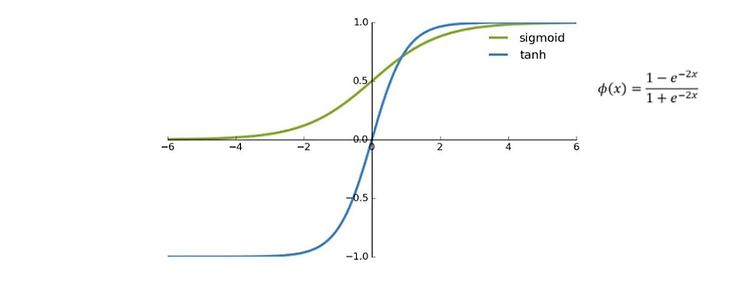

📌 이 글은 권철민님의 딥러닝 CNN 완벽 가이드를 바탕으로 정리한 내용입니다. 목차 Activation function Activation function를 왜 적용해야 할까? : 딥러닝 네트워크에 비선형성을 적용하기 위함 딥러닝 모델에서의 Activation function 적용 : Sigmoid, ReLU, Softmax Sigmoid 함수의 특성 : 이진 분류의 최종 Classification layer에서 쓰인다. Sigmoid 함수의 Vanishing gradient 문제 회귀를 이용한 분류에서 사용되는 Sigmoid Hyperbolic tangent ReLU(Recified Linear Unit) : 대표적인 은닉층의 활성화 함수 input이 0보다 작을 때, 0으로 출력 input이 0보다..